Наступне покоління чат-ботів зі штучним інтелектом і генераторів картинок видаватиме свої результати швидше. Прискорення їхньої роботи стало можливим завдяки новій відеокарті Nvidia HGX H200 Tensor Core. Вона використовує архітектуру Hopper і демонструє надвисоку продуктивність.

Новий графічний процесор – це продовження графічного процесора H100, випущеного минулого року та раніше найпотужнішого графічного процесора Nvidia для штучного інтелекту.

На думку експертів, недостатня обчислювальна потужність була основною перешкодою прогресу штучного інтелекту минулого року, заважаючи розгортанню існуючих моделей штучного інтелекту та сповільнюючи розробку нових.

Незважаючи на назву графічні процесори, ці призначені для центрів обробки даних чипи зазвичай не призначені для роботи з графікою. Графічні процесори ідеально підходять для додатків штучного інтелекту, оскільки вони виконують величезну кількість паралельних множень матриць, необхідних для функціонування нейронних мереж. Вони важливі в навчальній частині побудови моделі штучного інтелекту та частині виведення – коли люди вводять дані в модель штучного інтелекту, і вона повертає результати.

Наприклад, OpenAI неодноразово заявляв, що у нього мало ресурсів GPU, і це спричиняє уповільнення роботи з ChatGPT. Щоб надавати будь-які послуги, компанія повинна запроваджувати обмеження. Гіпотетично використання H200 може дати існуючим мовним моделям штучного інтелекту, які запускають ChatGPT, більше простору для обслуговування більшої кількості клієнтів.

За словами Nvidia, H200 є першим GPU, який пропонує пам’ять HBM3e. Завдяки HBM3e чип H200 пропонує 141 ГБ пам’яті та пропускну здатність 4,8 терабайт на секунду, що, за словами Nvidia, у 2,4 рази перевищує пропускну здатність пам’яті Nvidia A100, випущеного в 2020 році. Незважаючи на вік A100, він все ще користується високим попитом через дефіцит інших чипів.

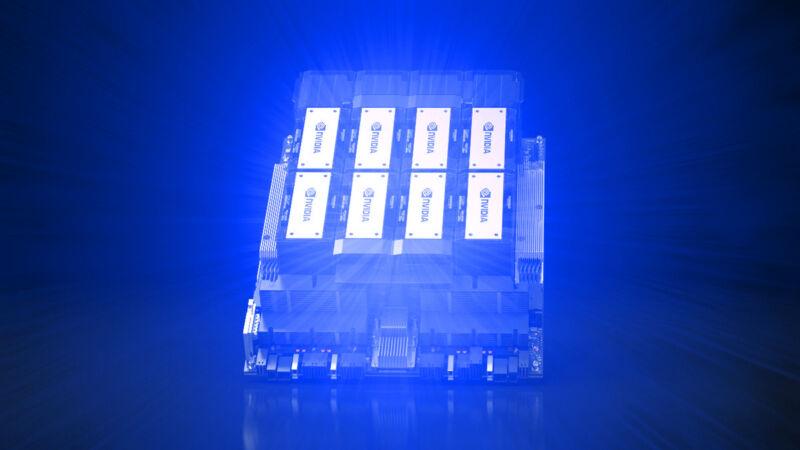

Nvidia випустить H200 у кількох форм-факторах. Сюди входять серверні плати Nvidia HGX H200 у чотирьох- та восьмиканальних конфігураціях, сумісні з апаратним і програмним забезпеченням систем HGX H100. Він також буде доступний у суперчипі Nvidia GH200 Grace Hopper, який поєднує центральний і графічний процесори в одному пакеті для ще більшого розвитку штучного інтелекту.

Amazon Web Services, Google Cloud, Microsoft Azure та Oracle Cloud Infrastructure стануть першими постачальниками хмарних послуг, які розгортатимуть екземпляри на основі H200, починаючи з наступного року, і Nvidia каже, що H200 буде доступний у глобальних виробників систем і постачальників хмарних послуг у 2 кварталі 2024 року.

Підписуйтесь на канал в Telegram та читайте нас у Facebook. Завжди цікаві та актуальні новини!